Tendencias en tecnología de datos 2026: cómo construir una infratructura realmente AI-ready

2026 marca un cambio práctico: Lakehouse, Data Fabric y Data Mesh dejan de ser “experimentos” y se vuelven el estándar para empresas que quieren una plataforma de datos lista para IA sin hundirse en complejidad y costo.

La forma más útil de leer estas tendencias no es como “herramientas”, sino como un sistema operativo de datos: backbone (Lakehouse), conectividad/gobierno de lo distribuido (Fabric) y modelo operativo por dominios (Mesh).

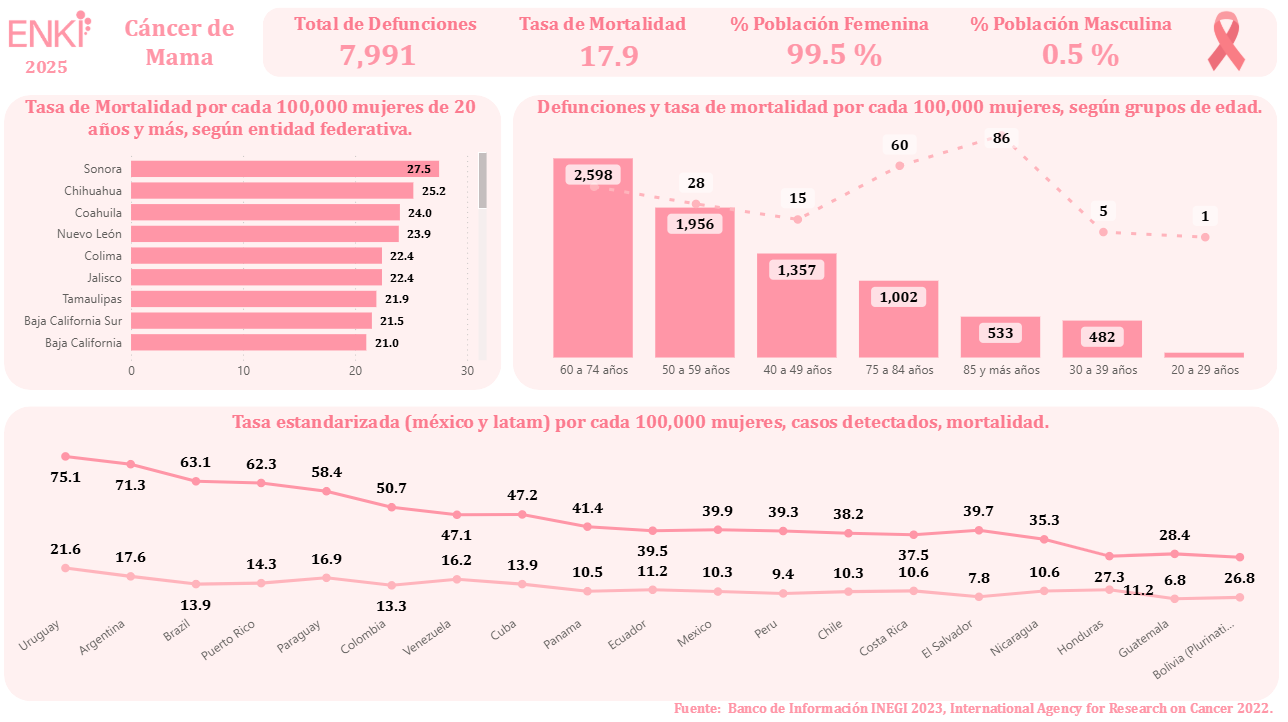

1) Arquitecturas modernas: Lakehouse + Fabric + Mesh (el combo que domina 2026)

Lakehouse como plataforma base. El gasto global en big data y analytics se proyecta en 420 mil millones de dólares para 2026, y el lakehouse se posiciona como evolución natural del stack “DW + data lake”: un backbone para BI, ML y GenAI sobre formatos abiertos.

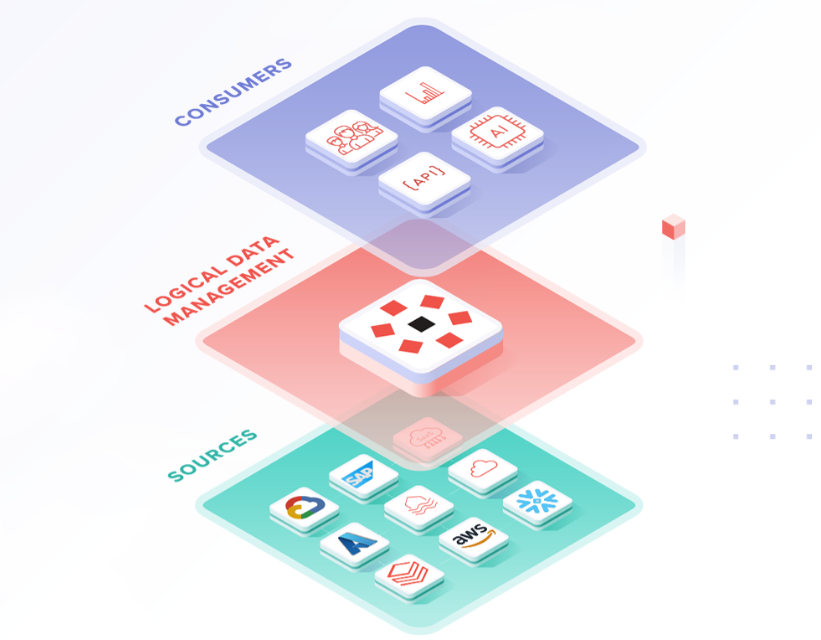

Data Fabric como capa para un mundo multi-cloud/híbrido. El mercado de Data Fabric se estimó en 2,545.5 M USD (2024) con CAGR 18.37% hacia 2032, reflejando una realidad: los datos viven distribuidos (nubes, on-prem, SaaS) y hay que conectar y gobernar, no solo “mover”.

Data Mesh como respuesta organizacional. Cerca del 84% de organizaciones encuestadas ya lo implementó total o parcialmente, buscando mejorar calidad (64%) y gobernanza (58%). En pocas palabras: dominios dueños de data products, sobre una plataforma común.

2) Multi-cloud e híbrido: el estado natural (y FinOps como freno de mano)

En 2026, multi-cloud e híbrido dejan de ser “casos especiales” y se vuelven el modelo operativo estándar.

Tres datos que explican por qué:

- 85%-89% de organizaciones grandes ya operan multi-cloud hacia 2026 (resiliencia, negociación, cumplimiento).

- Para 2027, 90% habrá adoptado nube híbrida (privado para datos sensibles/core regulado; pública para elasticidad e innovación).

- 72% de empresas excedieron su presupuesto cloud el último año fiscal: con GenAI (GPUs, tokens, egress) el gasto se dispara si no hay control.

La idea es simple: sin FinOps, multi-cloud e híbrido multiplican costos en vez de optimizarlos.

3) GenAI aplicada a datos empresariales: RAG + vector databases + agentes

2026 es el año en que GenAI pasa de experimental a una capa operativa esperada dentro de plataformas de datos e IA, integrada en BI, analítica y decisiones de negocio.

RAG: el patrón que hace GenAI confiable con datos empresariales

RAG se consolida como arquitectura dominante: antes de responder, recupera documentos relevantes y reduce alucinaciones. Además aporta datos frescos, trazabilidad de la fuente y menor costo vs fine-tuning continuo.

Se describe una evolución clara: RAG simple (top-k) → RAG híbrido (vectores + filtros) → RAG avanzado (re-ranking, multi-hop, graph-based).

Y hay dos números que importan:

- RAG se proyecta como dominante en IA empresarial, con tiempos típicos de 10–100 ms y capacidad de soportar millones de documentos.

- Más del 30% de empresas adoptará vector databases para enriquecer modelos con contexto propio hacia 2026.

Agentic AI: cuando la IA no solo responde, también actúa

Los agentes (sistemas que planifican y actúan sobre sistemas empresariales) pasan de prototipos a casos con impacto real: la capa “operativa” de GenAI.

4) MLOps + LLMOps: escalar IA sin incendios en producción

La disciplina evoluciona: la métrica pasa de MTTR a MTTA (Mean Time to Autonomy): qué tan rápido los sistemas se auto-reparan sin intervención humana.

Además, LLMOps se consolida como disciplina separada: los LLMs cambian más rápido (APIs, variabilidad de outputs, tokens) y requieren herramientas, métricas y workflows propios.

5) Tiempo real y “streaming lakehouse”: el fin del batch por costumbre

En 2026 la pregunta ya no es “¿necesitamos tiempo real?”, sino: “¿dónde seguimos haciendo batch que debería ser streaming?”

Se consolida la Data Streaming Platform (DSP): conectividad, procesamiento, almacenamiento y governance de datos en movimiento (Kafka/Flink), donde streaming deja de ser “otro ETL” y se vuelve backbone.

Y el patrón fuerte es Streaming + Lakehouse (Iceberg/Delta): un mismo backbone para real-time e histórico, sin duplicación.

Incluso se menciona 2026 como el año del “streaming lakehouse”: integrar Kafka/Flink con Iceberg/Delta para unificar datos en movimiento con almacenamiento analítico.

Descarga el eBook completo (sin formulario)

Si estás definiendo tu roadmap de datos e IA para 2026, aquí tienes el eBook completo en PDF con todo el detalle.